“`html

Anthropic,一家備受矚目的AI新創公司,近日對其Claude資料使用政策進行了重大調整。這項調整的核心在於,未來Claude用戶的對話內容是否能被用於模型訓練,將取決於用戶是否明確同意。這項政策的改變不僅關乎用戶的隱私權益,更可能影響Anthropic在AI模型開發上的競爭力。在AI技術快速發展的背景下,數據的價值日益凸顯,而Anthropic的這項舉措,無疑將引發業界對於資料使用倫理與政策的廣泛討論。

Anthropic 資料使用政策大轉彎:是進步還是隱憂?

過去,Anthropic向用戶保證,他們的對話內容會在系統後端自動刪除,最多保留30天。只有在用戶輸入違規內容時,相關資料才可能保留長達2年。然而,現在Anthropic希望將用戶的對話和程式碼編輯等紀錄用於訓練和改進模型,這意味著用戶的數據將被更長時間地保存和使用。Anthropic聲稱此舉旨在提升模型安全性,並讓模型在編碼、分析和推理等技能上進步,最終造福所有用戶。但背後更深層的原因是,Anthropic需要更多高品質的數據資料,以在競爭激烈的AI市場中保持領先。

新政策對用戶的影響:你必須知道的選擇權

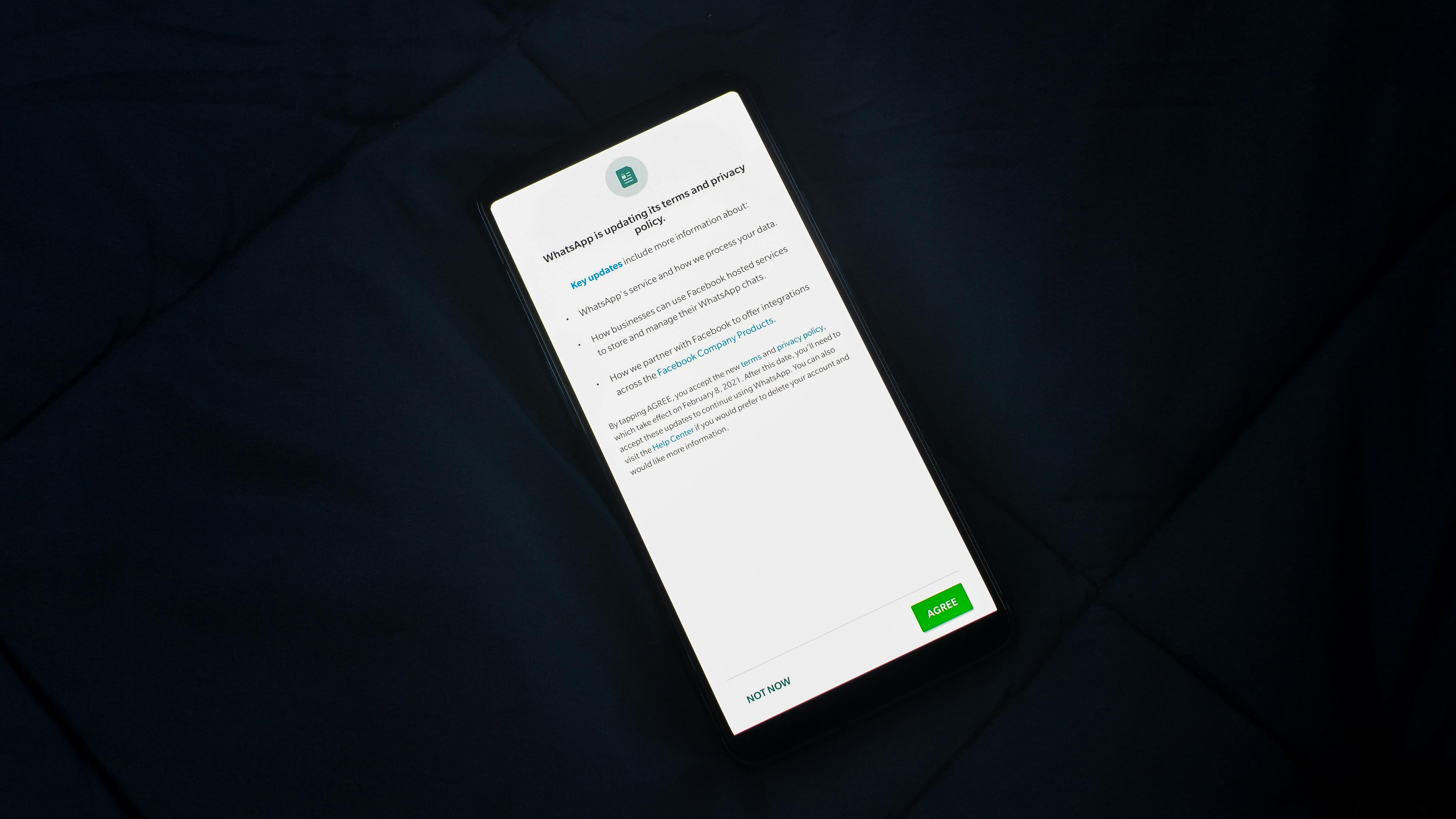

所有Claude用戶必須在2025年9月28日前決定,是否同意讓AI對話用於模型訓練。用戶可以在Claude的「Settings」→「Privacy」→ Privacy Settings 選項中審閱消費者服務條款和隱私政策。如果用戶沒有選擇退出,Anthropic會將用於訓練的用戶對話保留5年。這意味著,用戶如果不主動採取行動,就默認同意Anthropic使用他們的對話內容。

商業客戶不受影響:聚焦消費者市場

值得注意的是,這項政策變更僅適用於使用Claude免費版、Claude Pro 及 Claude Max(包含 Claude Code)的用戶。商業客戶,如果使用 Claude Gov、Claude for Work、Claude for Education 或存取 API,則不受影響。這顯示Anthropic更關注從消費者市場獲取訓練數據。

隱私疑慮與數據價值:AI發展的兩難

Anthropic將此變動包裝成「用戶自主選擇」,強調用戶可以「協助我們提升模型安全性」。然而,這種說法難以完全消除用戶對於隱私的疑慮。畢竟,將大量的個人對話內容用於AI模型訓練,存在潛在的風險,例如個人資訊洩露或被用於不當用途。另一方面,Anthropic也需要大量的數據來提升模型的性能,以與OpenAI、Google等競爭對手抗衡。這是一個AI發展過程中難以迴避的兩難:如何在保障用戶隱私的前提下,獲取足夠的數據來推動技術進步?

未來動向:使用者政策的透明化與個資保護的強化

隨著科技日新月異,隱私規定也必然跟著調整。Anthropic的這次政策變動,也提醒所有網路使用者,應更加關注自己在使用各項服務時的資料使用條款。未來,企業在使用用戶資料時,應更加透明化,清楚告知用戶資料的使用方式和目的,並提供更便捷的選擇退出機制。同時,政府也應加強個資保護的立法和監管,確保用戶的隱私權益得到充分保障。只有在建立在信任和尊重用戶隱私的基礎上,AI技術才能健康發展。

常見問題QA

- Q: 我需要做什麼才能避免我的對話被用於模型訓練?

A: 您需要在2025年9月28日前,前往Claude的「Settings」→「Privacy」→ Privacy Settings 選項,審閱消費者服務條款和隱私政策,並選擇退出。 - Q: Anthropic會如何使用我的對話內容?

A: Anthropic表示,您的對話內容將被用於提升模型安全性,並讓模型在編碼、分析和推理等技能上進步。

相關連結:

Share this content: