“`html

AMD 近期推出 Adrenalin Edition 25.8.1 版驅動程式,為搭載 Ryzen AI Max+ 395 處理器且配備 128GB 記憶體的電腦帶來令人振奮的消息!這項更新有望讓這些電腦在本地運行規模龐大的大型語言模型 (LLM),其參數量甚至可媲美 ChatGPT 3.0 的 128B 模型。這意味著筆記型電腦和小型工作站將不再受限於雲端服務,能夠更快速、更安全地處理複雜的 AI 任務。讓我們深入了解這項技術突破背後的重要意義和潛在影響。

Ryzen AI Max+ 與本地 LLM 推理:打破算力限制

過去,由於大型語言模型需要大量的顯示記憶體,往往只能在雲端伺服器上運行。這不僅需要網路連線,還可能涉及隱私和安全風險。AMD 的 Ryzen AI Max+ 395 處理器整合了強大的內建顯示晶片,並允許系統將高達 96GB 的主記憶體分配給顯示晶片使用。這使得在本地運行大型語言模型成為可能,消除了對雲端服務的依賴,同時提升了速度和安全性。

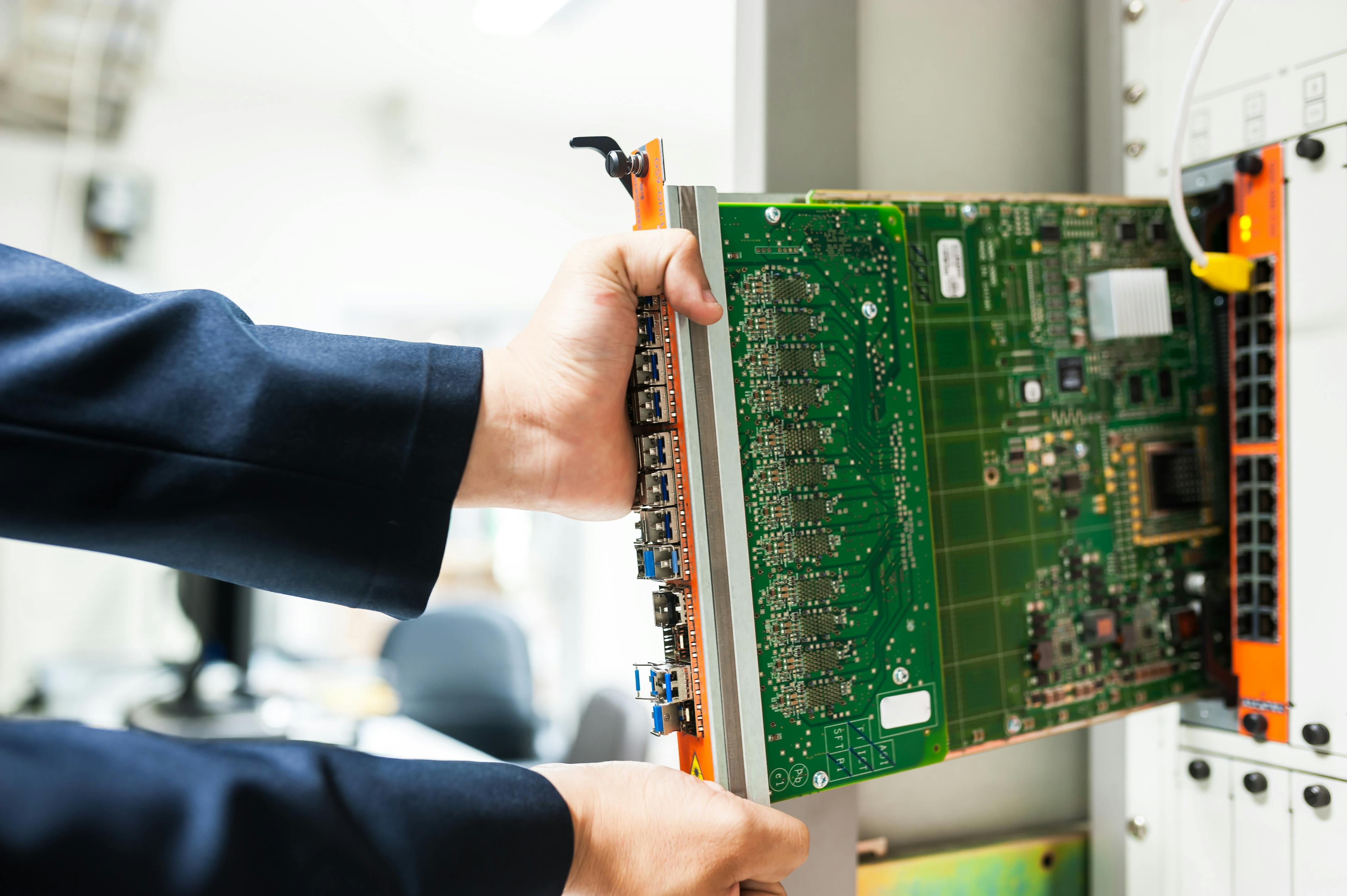

技術細節:RDNA 3.5 架構與記憶體配置

Ryzen AI Max+ 395 處理器採用了 AMD 最新的 RDNA 3.5 繪圖架構,擁有 40 組運算單元。更重要的是,在配備 128GB 記憶體的系統中,它可以將 96GB 的記憶體劃分為專屬顯示記憶體,並搭配 16GB 的共享記憶體。這種配置為執行參數量極大的模型提供了充足的記憶體空間,讓筆記型電腦和小型工作站也能處理以往只有雲端伺服器才能勝任的任務。

相關實例:應用場景與潛在用途

這項技術突破將為各行各業帶來廣泛的應用。例如,研究人員可以在本地運行複雜的科學模型,無需擔心網路延遲或數據安全問題。設計師可以利用大型語言模型進行更高效的創意發想和設計迭代。程式開發人員可以在本地測試和優化 AI 應用,而無需依賴雲端資源。此外,對於需要高度隱私保護的行業,如金融和醫療保健,本地運行大型語言模型可以有效降低數據洩露的風險。

令人興奮的優勢:效率、安全與可及性

這項技術的最大優勢在於提高了效率、安全性和可及性。本地運行大型語言模型可以顯著降低延遲,提高響應速度,從而提升工作效率。由於數據無需傳輸到雲端,可以更好地保護隱私和安全。此外,這項技術的普及將降低大型語言模型的使用門檻,讓更多人能夠接觸和利用 AI 的強大力量。然而,值得注意的是,要充分發揮這項技術的潛力,需要配備足夠的記憶體,這可能會增加硬體成本。

深入分析前景與未來動向:AI 普及的關鍵一步

AMD 的這項技術突破無疑是 AI 普及的重要一步。隨著硬體技術的不斷進步,我們有望在更多設備上看到本地運行大型語言模型的身影。未來,我們可以期待更小巧、更高效的 AI 晶片,以及更智能的記憶體管理技術。這將進一步降低 AI 的使用門檻,促進 AI 在各個領域的應用,最終改變我們的生活和工作方式。

常見問題QA

- Q: Ryzen AI Max+ 395 處理器是否相容於所有主機板?

A: Ryzen AI Max+ 395 處理器需要相容的主機板才能正常運行,具體請參考主機板廠商的規格說明。 - Q: 128GB 記憶體是必須的嗎?

A: 為了充分利用 Ryzen AI Max+ 395 處理器的 AI 能力,建議配備 128相關連結:

Share this content: