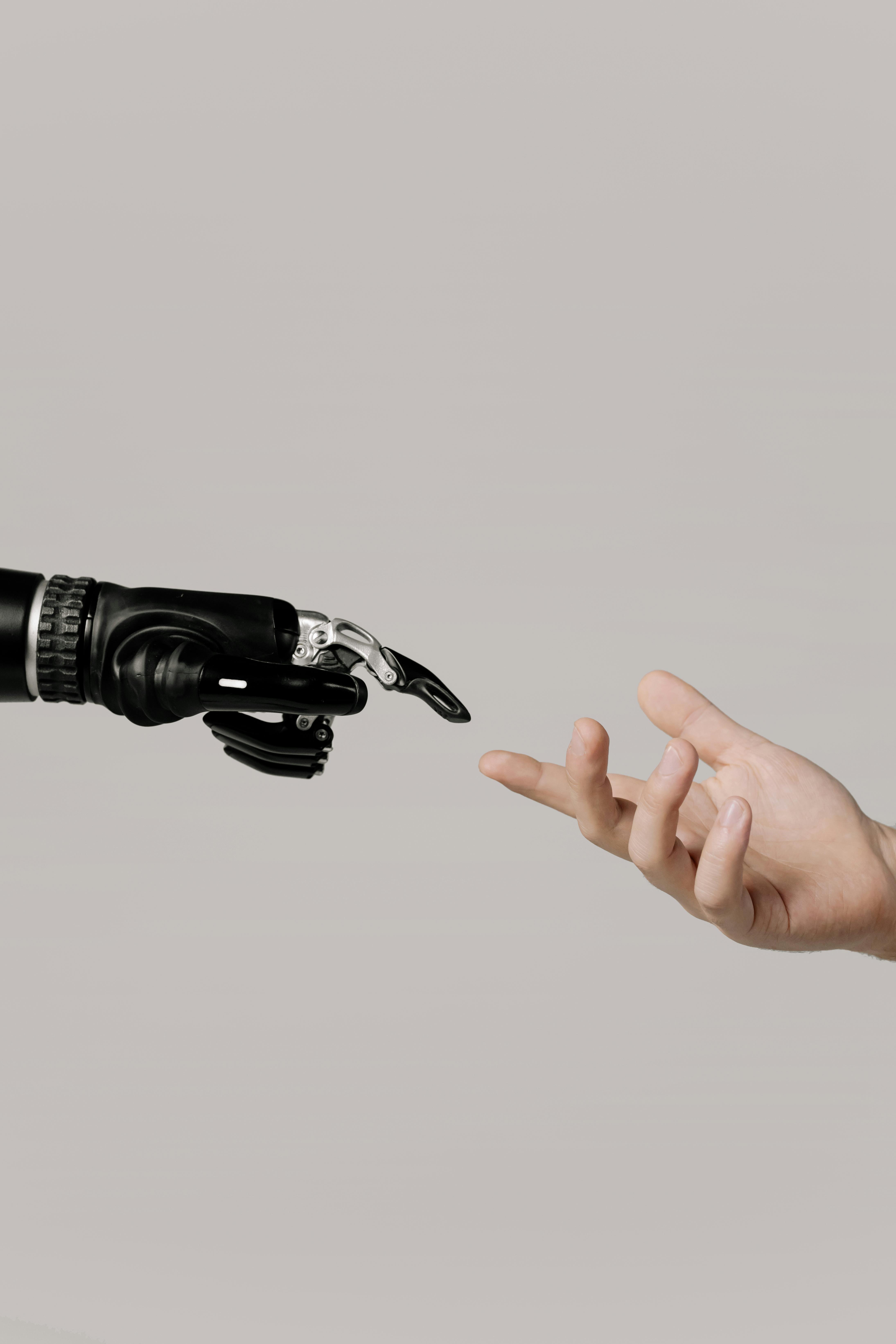

在人工智慧領域,語言模型的安全性一直備受關注。傳統的基於規則的系統雖然簡單,但在安全特性至關重要的領域依然發揮著重要作用。而近年來,大型語言模型的發展日新月異,但其幻覺等問題也成為安全隱患。為了提升語言模型的安全性,OpenAI 安全團隊提出了一項新的研究成果,即使用基於規則的獎勵機制來強化模型的安全特性,這讓人不禁聯想到科幻作家以撒·艾西莫夫提出的「機器人三定律」,似乎OpenAI正在向著建立一套自然語言規則來指導 AI 系統安全發展的方向邁進。

突破性的安全機制

OpenAI 的「基於規則的獎勵」機制源自於 RLHF 和 RLAIF 研究成果,其核心思想是利用自然語言規則來定義模型的期望行為,並將這些規則轉化為獎勵訊號,從而指導模型的訓練過程。

該機制將期望行為分解成具體的自然語言規則,這些規則明確描述了人們想要的或不想要的行為。例如,拒絕時應包含簡短的道歉,拒絕時不應評判使用者等。這些規則類似於艾西莫夫機器人定律,為 AI 系統設定了安全行為準則。

這種方法可以對模型進行細微性的控制,並提高 LLM 分類的準確度。此外,將規則直接融入 RL 訓練過程中,避免了行為規範在蒸餾到獎勵模型時可能發生的損失。

令人驚嘆的成果

未來發展趨勢

常見問題QA

基於規則的獎勵機制可以有效提升語言模型的安全性,但並不能完全解決所有安全問題。隨著 AI 技術的發展,我們需要不斷探索新的安全機制,以確保 AI 的安全可靠。

基於規則的獎勵機制旨在提升安全性,並不會限制語言模型的創造力。相反,它可以讓模型在安全的範圍內更加自由地發揮創意。

相關連結:

siuleeboss – 为您提供一站式的有用AI资讯、食谱和数位教学

Share this content: