ChatGPT 的開發者 OpenAI 宣布與國防科技公司 Anduril Industries 合作,計畫開發類似 GPT-4o 和 GPT-4o1 的 AI 模型,協助美國及其盟友抵禦空中攻擊。這一合作引發了人們對於 AI 在戰爭中角色的擔憂,以及 OpenAI 在道德和軍事應用的立場上的轉變。

OpenAI 涉足軍事領域:AI 的道德困境

OpenAI 此前曾表明反對將其技術用於武器開發或軍事戰爭,但這次合作卻打破了這一立場。這引發了許多人對 OpenAI 道德立場的質疑,以及 AI 技術被用於軍事用途的潛在風險。

隨著 AI 技術的發展,其在戰爭中的應用也越來越廣泛。從無人機的自動控制到戰場情報的分析,AI 技術正在改變著戰爭的面貌。然而,AI 的應用也帶來了一些倫理上的問題,例如機器人是否應該擁有殺人權力?AI 武器的開發是否會加速軍備競賽?

其他延伸主題

除了 OpenAI 和 Anduril Industries 之外,其他 AI 公司也積極涉足國防領域,例如 Anthropic 與 Palantir 合作處理機密政府數據,Meta 向國防合作夥伴提供其 Llama 模型。

AI 在戰爭中的優勢包括提高效率、減少人員傷亡、提供更準確的情報等。但 AI 也存在著一些劣勢,例如容易被黑客攻擊、可能出現錯誤判斷等。

相關實例

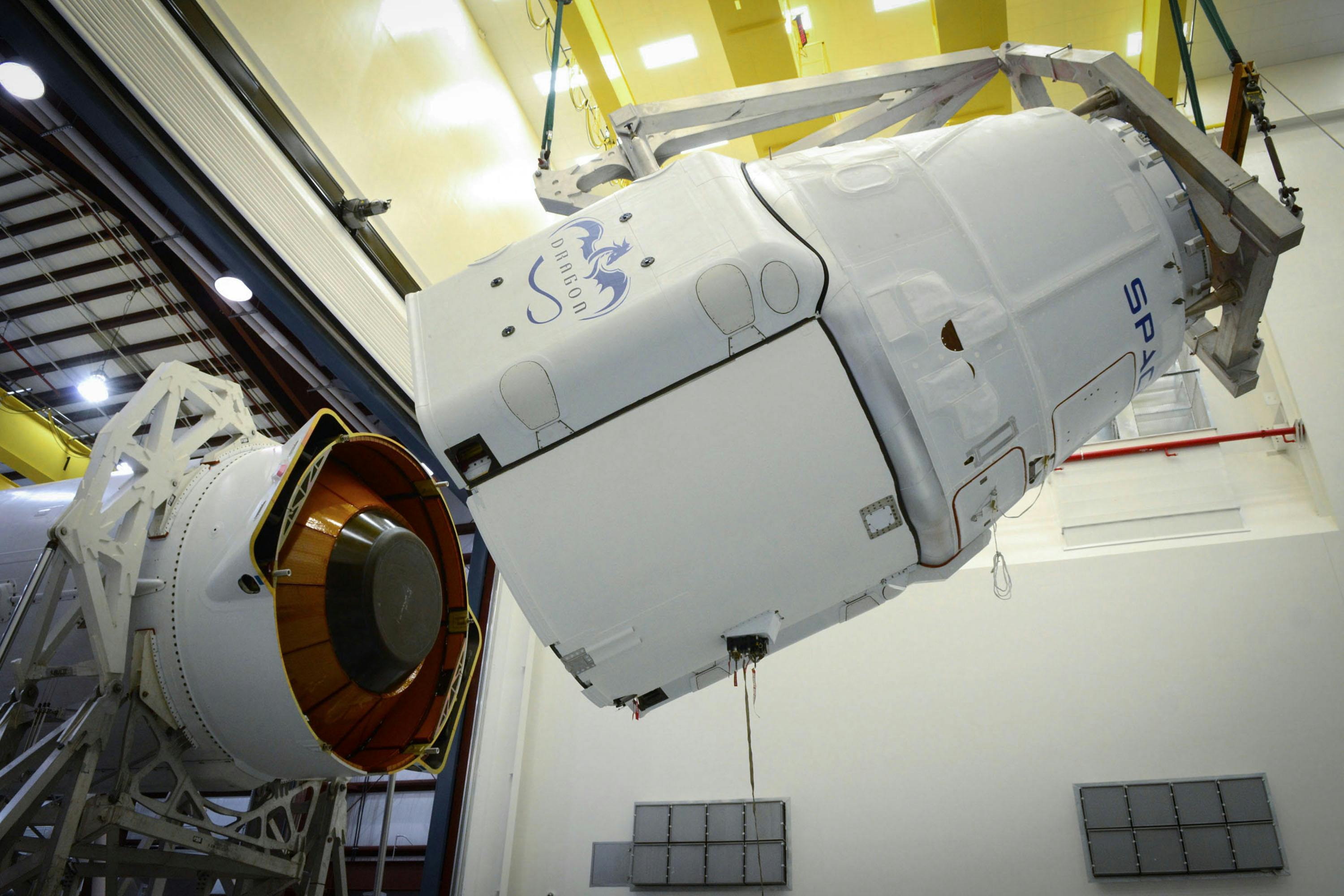

Anduril Industries 目前生產多種可能被用於殺人的產品,包括 AI 驅動的暗殺無人機和導彈用火箭發動機。

美國五角大廈對 AI 系統表現出越來越大的興趣,並啟動了像「Replicator 」這樣的計畫,以便在未來兩年內部署數千個自主系統。

優勢和劣勢的影響分析

大型語言模型 (LLM) 容易受到提示注入(prompt injection)等操縱漏洞的影響,這可能會導致使用 LLM 執行軍事任務出現嚴重缺陷。

在生死攸關的軍事情況下使用潛在不可靠的 LLM 技術引發了關於安全性和可靠性的重要問題。

深入分析前景與未來動向

隨著 AI 技術的進步,AI 武器的開發將會更加迅速。這可能會導致軍備競賽加劇,以及 AI 武器的倫理問題更加突出。

AI 技術在戰爭中的應用將會越來越廣泛,但 AI 武器的倫理問題也需要得到重視。如何確保 AI 武器的安全性、可靠性和道德性,將成為未來發展的關鍵問題。

常見問題QA

OpenAI 表示,他們與 Anduril Industries 的合作夥伴關係將有助於確保 OpenAI 技術保護美國軍事人員,並將幫助國家安全界理解並負責任地使用這項技術來保障我們公民的安全和自由。

隨著 AI 技術的進步,AI 武器的開發將會更加迅速,這可能會導致軍備競賽加劇。

這是一個複雜的問題,需要全球各國共同努力,制定相關的法律法規和倫理準則。

相關連結:

Share this content: